Angle

Os fundamentos de dados para a adoção responsável da IA

- Information governance

- 3 mins

À medida que a IA se integra aos fluxos de trabalho das empresas, os líderes jurídicos e de conformidade estão assumindo uma nova função: não apenas gerenciar riscos, mas também definir a estratégia de dados para a estrutura, os controles e a responsabilidade necessários para adotar a IA de forma responsável, incluindo ferramentas para toda a empresa, como o Copilot para Microsoft 365.

Esta série explora como as equipes jurídicas e de conformidade podem liderar a preparação para uma IA responsável.

A promessa e as armadilhas

A IA oferece uma nova ferramenta poderosa para otimizar tarefas de profissionais do conhecimento, como criação de estratégias de marketing, propostas de orçamento financeiro, análise competitiva e resumo de casos de atendimento ao cliente. No entanto, os mesmos recursos que tornam a IA tão atraente também colocam dados confidenciais em risco de exposição excessiva.

Antes da adoção generalizada da IA, os métodos de armazenamento e acesso a dados variavam entre empresas e até mesmo entre funções. Os usuários e até mesmo a liderança muitas vezes tinham uma compreensão limitada sobre quais informações confidenciais estavam acessíveis e por quem, contando com a falta de conscientização da maioria dos funcionários para manter documentos confidenciais em segurança.

Agora, ferramentas como o Microsoft Copilot podem acessar e exibir qualquer dado que o usuário tenha permissão para visualizar. Isso pode revelar inadvertidamente conteúdo confidencial (por exemplo, documentos de estratégia de negócios, comunicações privilegiadas ou informações de identificação pessoal (PII)) que nunca deveriam ser amplamente compartilhados.

Historicamente, os controles de acesso foram projetados para fluxos de trabalho manuais. Um usuário pode ter acesso a milhares de arquivos, mas sem um prompt de pesquisa ou navegação direta, ele nunca encontraria a maioria deles. A IA muda isso. Ela sintetiza e revela informações de todo o conjunto de dados, produzindo novos conteúdos que colocam detalhes confidenciais em risco. Essa mudança exige uma abordagem intencional e cautelosa à governança de dados.

Compreendendo seu patrimônio de dados

Antes de habilitar a IA, as equipes jurídicas devem analisar cuidadosamente todo o seu panorama de dados. Isso inclui saber onde os dados estão armazenados, conhecer as permissões de acesso e o tipo de informação que sua organização classifica como “confidencial”. Identificar os critérios para informações confidenciais é um primeiro passo fundamental para limitar as permissões de acesso sem deixar os dados vulneráveis.

Essa fase de descoberta é a base para a implementação da IA. Não apenas no que diz respeito à conformidade com as leis de privacidade, mas também à compreensão de quais dados devem ser retidos por motivos regulatórios, o que deve ser excluído de forma justificável e com que rigor as permissões dos usuários devem ser alteradas.

A qualidade dos dados da sua organização desempenha um papel significativo na produção de resultados eficazes. A realidade do uso da IA para melhorar os fluxos de trabalho e a produtividade é que seus resultados serão diferentes quando a qualidade dos dados for insuficiente. Muitas organizações passam anos acumulando dados, e o surgimento da IA está forçando uma avaliação há muito esperada da qualidade e retenção dos dados.

Classificação e proteção

Nem todos os dados são criados da mesma forma, e seus controles de segurança devem refletir isso. Conteúdos altamente confidenciais devem ser criptografados, rastreados e monitorados. Dados menos confidenciais podem exigir controles mais leves, mas ainda assim devem ser monitorados.

É aqui que entram em cena especialistas em IA responsáveis e ferramentas como o Microsoft Purview. Ao aplicar classificadores treináveis e rótulos de sensibilidade, as organizações podem automatizar a identificação e a proteção de dados críticos. Ferramentas de prevenção contra perda de dados (DLP) em tempo real e de gerenciamento de riscos internos atuam sobre essas classificações para bloquear ações arriscadas, alertar usuários ou acionar alertas.

Educar e capacitar

Mesmo os melhores controles técnicos não podem evitar todos os erros. A educação e o treinamento dos usuários são essenciais para garantir a conformidade holística. Muitos profissionais não são treinados para aproveitar adequadamente a engenharia de prompts ou as nuances da implantação da IA. Os resultados de um prompt bem elaborado e específico de um usuário variam muito em relação a um novo usuário que faz prompts vagos para a IA.

O treinamento do usuário deve se concentrar tanto no “como” quanto no “porquê”. Ensine os usuários a escrever prompts eficazes, mas também os ajude a entender as implicações das permissões de conteúdo da IA. Treine diferentes equipes funcionais separadamente, usando casos de uso que se aplicam diretamente ao seu trabalho. Por fim, lembre aos usuários que a IA não é um mecanismo de busca; é um colaborador que requer instruções claras e supervisão crítica.

Crie uma estrutura resiliente

As organizações devem aceitar que nenhuma estrutura de IA responsável pode ser perfeita. Qualquer grau de compartilhamento de conteúdo pode introduzir riscos, como a exposição não intencional de dados confidenciais e prompts e respostas de IA que não funcionam como pretendido. Compartilhar informações em excesso pode prejudicar os esforços de implementação e aumentar a probabilidade de erros relacionados ao amplo acesso aos dados ou ao gerenciamento de prompts. Por outro lado, esquemas de compartilhamento excessivamente restritivos interromperão a colaboração.

Uma estrutura de IA responsável reconhece isso e encontra o equilíbrio certo com base na propensão ao risco aceita pela organização. Para permitir a colaboração e, ao mesmo tempo, mitigar os riscos inerentes associados, as organizações devem implementar procedimentos sistemáticos para lidar com a superexposição de dados, monitorar continuamente as interações de IA, auditar resultados e melhorar os controles de acesso. É altamente recomendável utilizar um modelo de acesso “menos permissivo”, no qual os usuários têm acesso apenas às informações relevantes para suas responsabilidades.

Adoção responsável da IA

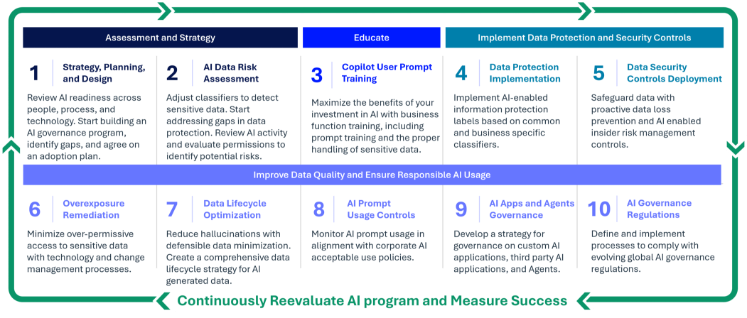

Há dezoito meses, a Epiq lançou sua oferta de IA responsável e preparação para copiloto com a visão de capacitar as organizações a aproveitarencial da IA, mantendo os mais altos padrões de segurança e conformidade de dados. A oferta inclui dez etapas, começando com uma avaliação, colocando rapidamente o copiloto nas mãos de seus usuários na terceira etapa e protegendo a longo prazo contra a superexposição de dados nas etapas quatro a dez.

Desde então, as equipes jurídicas têm observado um aumento no interesse por ferramentas de IA que aumentam a produtividade organizacional, melhoram a precisão e revelam novas formas de trabalhar. À medida que as organizações correm para adotar essas tecnologias, uma verdade se tornou clara: sem uma estratégia de segurança de dados claramente definida, os riscos superam os benefícios.

Conclusão

A IA tem o potencial de transformar o trabalho, mas somente se for implementada com cuidado e intencionalidade. Ao investir na descoberta de dados, classificação, educação do usuário e proteção proativa, as organizações podem aproveitar os benefícios da IA sem comprometer a segurança ou a conformidade.

Fique atento ao primeiro passo desta série de blogs: Estratégia, planejamento e classificação.

Jon Kessler, vice-presidente e gerente geral, Governança da Informação, Epiq

Jon Kessler é vice-presidente e gerente geral de Governança da Informação na área de Soluções Jurídicas da Epiq, onde lidera uma equipe global focada em ajudar os clientes a explorar o valor do Microsoft Purview por meio de serviços de IA responsável e preparação para o Copilot. Sua equipe presta consultoria em uma ampla gama de áreas de governança e conformidade, incluindo Microsoft Copilot, privacidade de dados, risco interno, retenção legal, gerenciamento de registros e processos de dados de fusões e aquisições. Sob sua liderança, a equipe foi reconhecida como Parceira de Conformidade do Ano da Microsoft, sendo finalista em 2022 e 2024 e vencedora em 2023.

Desde que assumiu o cargo de vice-presidente e gerente geral, Jon dobrou o tamanho e a receita do negócio de Governança da Informação, ao mesmo tempo em que aprofundou o alinhamento com o ecossistema de conformidade da Microsoft. Com experiência em perícia digital e eDiscovery, ele liderou mais de 600 investigações forenses, atuou como testemunha especialista em tribunais federais e estaduais e treina regularmente agências governamentais e empresas da Fortune 500 em IA, conformidade e tecnologia jurídica.

O conteúdo deste artigo é destinado apenas a fornecer informações gerais e não a oferecer aconselhamento ou opiniões jurídicas.