Angle

Avaliação de riscos de dados: possibilitando a adoção da IA

- 2 Mins

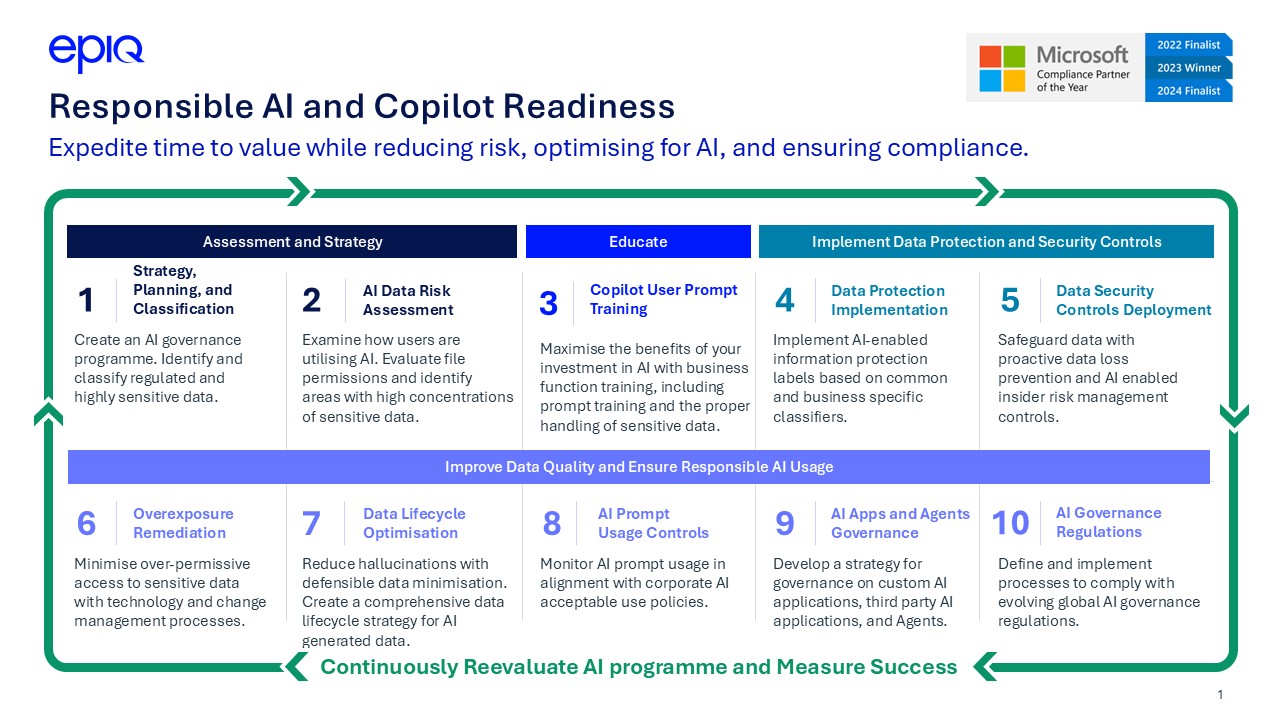

Com os dados no centro de qualquer negócio altamente funcional e maduro, ferramentas de IA como o Microsoft Copilot e o Gemini estão expondo vulnerabilidades no gerenciamento de informações confidenciais. Como essas tecnologias estão incorporadas nos fluxos de trabalho diários, o risco elevado de exposição excessiva de informações confidenciais não pode ser ignorado. Uma avaliação de risco de dados de IA atua como sua primeira linha de defesa, garantindo que os dados confidenciais sejam protegidos desde o início, ao mesmo tempo em que aproveita o poder da automação.

O que é uma avaliação de risco de dados de IA?

Uma avaliação de risco de dados de IA é uma forma de as organizações identificarem e protegerem eficazmente informações confidenciais, continuando a adotar ferramentas de IA como o Copilot. Os principais componentes incluem a descoberta automatizada de dados, a classificação, a monitorização do acesso e a aplicação de políticas. Isto permite compreender o conteúdo do seu património de dados, fornece informações sobre os fluxos de dados durante as interações de IA entre plataformas e apoia os esforços de mitigação de riscos.

Considerando a maior vulnerabilidade dos dados armazenados online e acessíveis à IA, as organizações estão cada vez mais atentas aos riscos de vazamento de dados. Sejam informações confidenciais, registros de funcionários ou dados comerciais proprietários, sem os controles adequados, as ferramentas de IA podem inadvertidamente expor essas informações em várias plataformas por meio de prompts, respostas ou integrações com plataformas externas.

Minimizar o risco de dados significa controlar as informações confidenciais dentro da organização, saber onde esses dados estão armazenados e entender quem tem acesso a eles. As avaliações de risco também devem levar em consideração ferramentas e integrações de IA de terceiros, fornecendo informações sobre onde os dados podem fluir fora do controle direto da organização. Exemplos específicos incluem dados pessoais, registros financeiros e informações regulamentadas, como Payment Card Industry (PCI) ou Personally Identifiable Information (PII). À medida que a IA avança, muitas organizações utilizam várias ferramentas ao mesmo tempo para realizar diferentes tarefas. Em cada plataforma, os dados são armazenados e acessados, ficando assim vulneráveis à exposição. A realização de avaliações de risco de dados de IA permite que as organizações antecipem áreas de exposição e risco regulatório, estabelecendo uma estrutura sólida para a implantação responsável da IA.

As empresas já não protegem os dados confidenciais?

Embora muitas organizações tenham protocolos de segurança de dados ativos, as ferramentas tradicionais de proteção de dados, como Prevenção de Perda de Dados (DLP) e Gerenciamento de Risco Interno (IRM), foram projetadas para e-mail, compartilhamento de arquivos e plataformas de colaboração. A IA introduz novos vetores para exposição de dados que essas ferramentas não foram projetadas para lidar sozinhas. Isso introduz a necessidade de monitorar as tecnologias de IA, independentemente de elas estarem dentro do ecossistema de dados ou externas.

A Microsoft oferece o Gerenciamento da Postura de Segurança de Dados para IA (DSPM para IA) como um componente do Microsoft Purview. Essa solução pode ser usada em conjunto com as políticas de Prevenção contra Perda de Dados (DLP) e Gerenciamento de Riscos Internos (IRM). Ela examina os conjuntos de dados em busca de possíveis vulnerabilidades e fornece recomendações com base em sua análise. O DSPM para IA permite que as organizações observem e gerenciem o fluxo de dados entre aplicativos de IA e sistemas internos. Por meio da integração com DLP e IRM, o DSPM para IA oferece recursos exclusivos de monitoramento de IA e oferece suporte à aplicação de políticas em ambientes tradicionais e de IA.

Para as equipes jurídicas, isso significa obter visibilidade sobre como os dados confidenciais são acessados, compartilhados ou usados nas interações de IA sem reformular a infraestrutura de segurança existente.

Adaptando os controles de risco de dados de IA à sua organização

Classificadores são regras ou modelos que detectam informações confidenciais em todos os dados de uma organização. O DSPM para IA permite que os usuários personalizem classificadores para refletir o perfil de risco exclusivo de sua organização, criando políticas padrão com base em análises.

Os departamentos jurídicos e de conformidade podem trabalhar com as equipes de TI e segurança para ajustar os classificadores com base em obrigações regulatórias, requisitos de confidencialidade ou políticas internas de prevenção de riscos. Você pode editar os tipos de informações existentes, criar classificadores personalizados e aplicá-los à sua política de DSPM, tudo em um portal centralizado.

Essa flexibilidade garante que os controles de risco de IA não sejam padronizados. Em vez disso, eles evoluem de acordo com as necessidades e as obrigações legais e regulatórias de cada organização.

Usando recomendações integradas da Microsoft para classificadores

Para organizações que não sabem por onde começar, a Microsoft oferece recomendações automatizadas de classificadores com base na análise de tráfego em tempo real. Essas recomendações ajudam a identificar comportamentos de alto risco, como o upload de dados confidenciais para sites de IA ou o envio de solicitações que podem expor informações confidenciais.

A capacidade de combinar ferramentas como o DSPM para IA com outras ofertas da Microsoft, como o DLP, permite que os usuários operem fluxos de trabalho eficientes em um sistema unificado, garantindo a segurança dos dados.

Estrutura de governança de IA: engatinhar, andar, correr

As organizações podem utilizar um modelo de “engatinhar, andar, correr” para implementar novas políticas com as partes interessadas. O processo inclui:

- Engatinhar: implantar políticas em modo de auditoria para observar o comportamento sem aplicação.

- Andar: monitorar e alertar as partes interessadas quando elas violarem uma nova política, mas não bloquear o comportamento.

- Correr: aplicar políticas para bloquear ações arriscadas e garantir a conformidade.

Essa abordagem em fases permite que as organizações equilibrem segurança e usabilidade, evitando interrupções enquanto constroem uma estrutura estratégica de governança de IA. Cada fase deve ser apoiada por métricas como taxas de violação de políticas, adoção pelo usuário e tempos de resposta a incidentes para orientar o progresso e garantir a responsabilidade. A estrutura deve ser adaptável com base nos perfis de risco. Casos de uso de alto risco podem exigir um progresso mais rápido para a aplicação, enquanto áreas de baixo risco podem permanecer no modo de auditoria por mais tempo.

O que as equipes jurídicas e de conformidade ganham com uma avaliação de riscos

A realização de uma avaliação de riscos de dados de IA por meio do DSPM para IA oferece vários benefícios que ajudam a abordar proativamente a governança da IA. Ele permite uma implantação rápida com configuração mínima, evita o vazamento de dados em prompts e respostas de IA, monitora comportamentos antiéticos e fornece suporte para conformidade regulatória com estruturas como GDPR, HIPAA, NIST e RMF. O DSPM para IA também oferece suporte à aplicação de políticas, permitindo controles de governança automatizados e trilhas de auditoria para interações de IA. Ele fornece recursos de monitoramento e alerta em tempo real que ajudam as equipes a responder rapidamente a possíveis usos indevidos de dados ou violações de políticas e promove a colaboração entre as equipes jurídicas, de risco, conformidade, segurança e dados para garantir uma governança unificada em todas as iniciativas de IA. Esses recursos garantem que a inovação não ocorra em detrimento da conformidade ou da confidencialidade.

Proteção de dados ao usar ferramentas de IA de terceiros

Embora o Copilot seja totalmente compatível com o Purview de forma nativa, a cobertura para ferramentas de IA de terceiros pode ser controlada usando conectores ou integrando o SDK do Purview em aplicativos de IA desenvolvidos sob medida. A Microsoft está trabalhando ativamente para ampliar a visibilidade e o controle para plataformas adicionais, oferecendo às organizações uma visão mais abrangente dos riscos associados à implementação da IA, como divulgação inadvertida de informações confidenciais, falta de trilhas de auditoria ou não conformidade com as leis jurisdicionais de privacidade de dados. Essa lacuna de visibilidade deixa as organizações expostas a riscos que estão fora da estrutura de governança da Microsoft. Para preencher essa lacuna, as equipes jurídicas e de TI devem considerar soluções complementares que ampliem o monitoramento e a aplicação de políticas em toda a IA em uso. Uma abordagem voltada para o futuro permite que as organizações se antecipem aos riscos emergentes à medida que essas ferramentas continuam a se desenvolver. As equipes jurídicas devem se envolver proativamente com as partes interessadas de TI e governança para definir políticas de uso aceitáveis e implementar ferramentas de monitoramento que vão além dos ecossistemas da Microsoft.

Grande risco traz grande responsabilidade

A avaliação de riscos de dados de IA não é apenas uma preocupação de TI; é uma prioridade legal e de conformidade. Ao integrar ferramentas como o DSPM para IA em sua estratégia de governança, as organizações protegem dados confidenciais, garantem a conformidade regulatória e apoiam a adoção responsável da IA. Antes de mergulhar de cabeça na adoção da IA, uma estrutura sólida de governança de dados servirá como uma base forte para avançar com confiança.

Manikandadevan Manokaran, consultor sênior de segurança de dados, Epiq

Manikandadevan é um consultor focado no cliente, com mais de 16 anos de experiência em tecnologias Microsoft. Ele é especialista em migração para a nuvem, segurança e conformidade. Manikandadevan tem uma grande paixão por ajudar as organizações a modernizar seus ambientes de dados com soluções inteligentes de IA.

O conteúdo deste artigo é destinado apenas a fornecer informações gerais e não a oferecer aconselhamento ou opiniões jurídicas.